صفحات بلاک شده یا Blocked by robots نشاندهنده صفحاتی ضعیف هستند که توسط ربات گوگل خزش نشدهاند. در واقع دلیل اصلی عدم خزش همین مسدودشدن صفحات است که میتواند به دلایل مختلفی اتفاق افتد. اگر صفحات وبسایت شما چنین اخطاری را نشان دهند، خبر بدی خواهد بود. این اخطار نشاندهنده این است که وبسایت شما در نتایج گوگل نشان داده نخواهد شد. مشکل این صفحات ایندکس شده اگرچه توسط ربات مسدود شدهاند اما قابل حل هستند. میتوانید URL های آسیب دیده خود را در نتایج جستجو مشاهده کنید حتی اگر با دستورالعملهای سختتر مسدود شدهاند. شایان ذکر است که مسئله بلاک صفحات ارتباط مستقیمی با ایندکس آنها دارد. از آنجا که رفع این مشکلات در قلب ایجاد یک استراتژی خزش و نمایهسازی است بیایید تا کمی بیشتر در این خصوص بحث کنیم.

فهرست مطالب

خطای Blocked by robots چیست؟

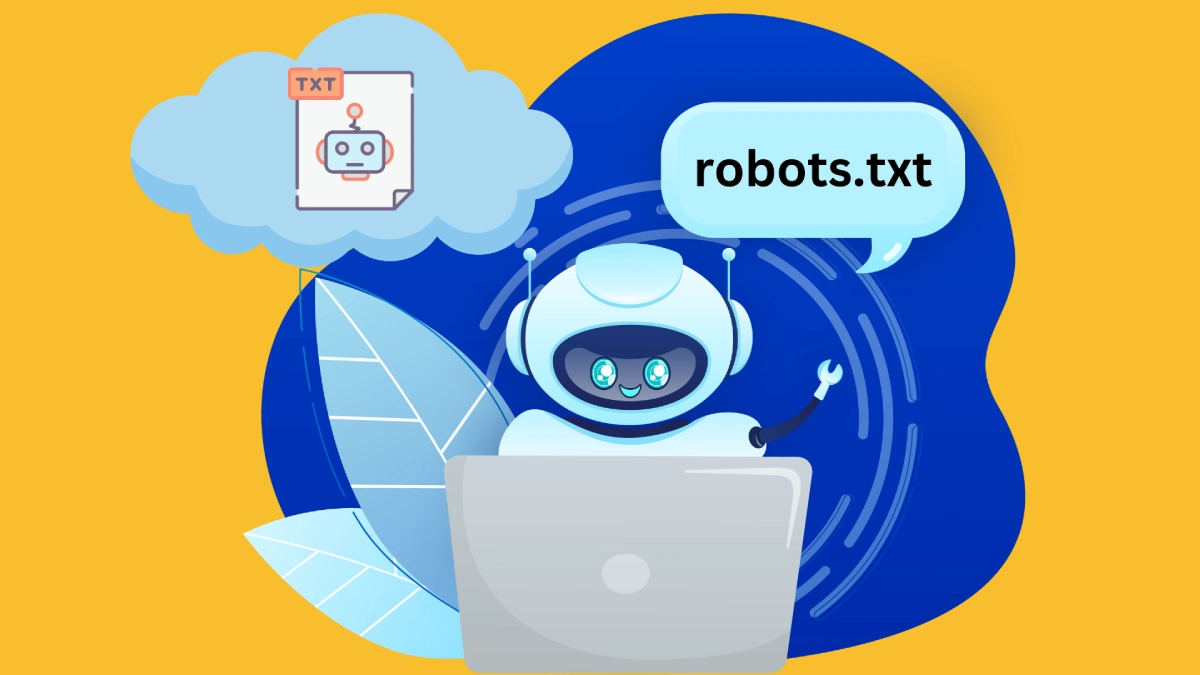

در زمان طراحی سایت باید فایل Robots.txt را در مسیر درست آن قرار داد تا کار بهراحتی جلو رود. قطعا دیدن چنین خطایی برای کاربر هم کلافهکننده است و صاحب کسبوکار دیجیتال را با سختیهای زیادی مواجه میکند. این خطا مستقیما با ایندکسبودن یا نبودن سایت مورد نظر در ارتباط است؛ بنابراین اهمیت زیادی دارد. ممکن است تمام استراتژیهای لازم را بهکار گرفته باشید، اما باز هم با چنین خطایی مواجه شوید. وقتی با این خطا مواجه میشوید به این معنی است که فایل Robots.txt در وبسایت از خزش آن جلوگیری میکند. بهطور کلی وقتی ایجاد میشود که فایل مورد نظر از پیکربندی خوبی برخوردار نیست. اما رابطه ایندکسکردن و بلاک صفحات بسیار مهم است که در ادامه بهصورت مختصر به آنها پرداختهایم.

چطور میتوان خطای Blocked by robots را تشخیص داد؟

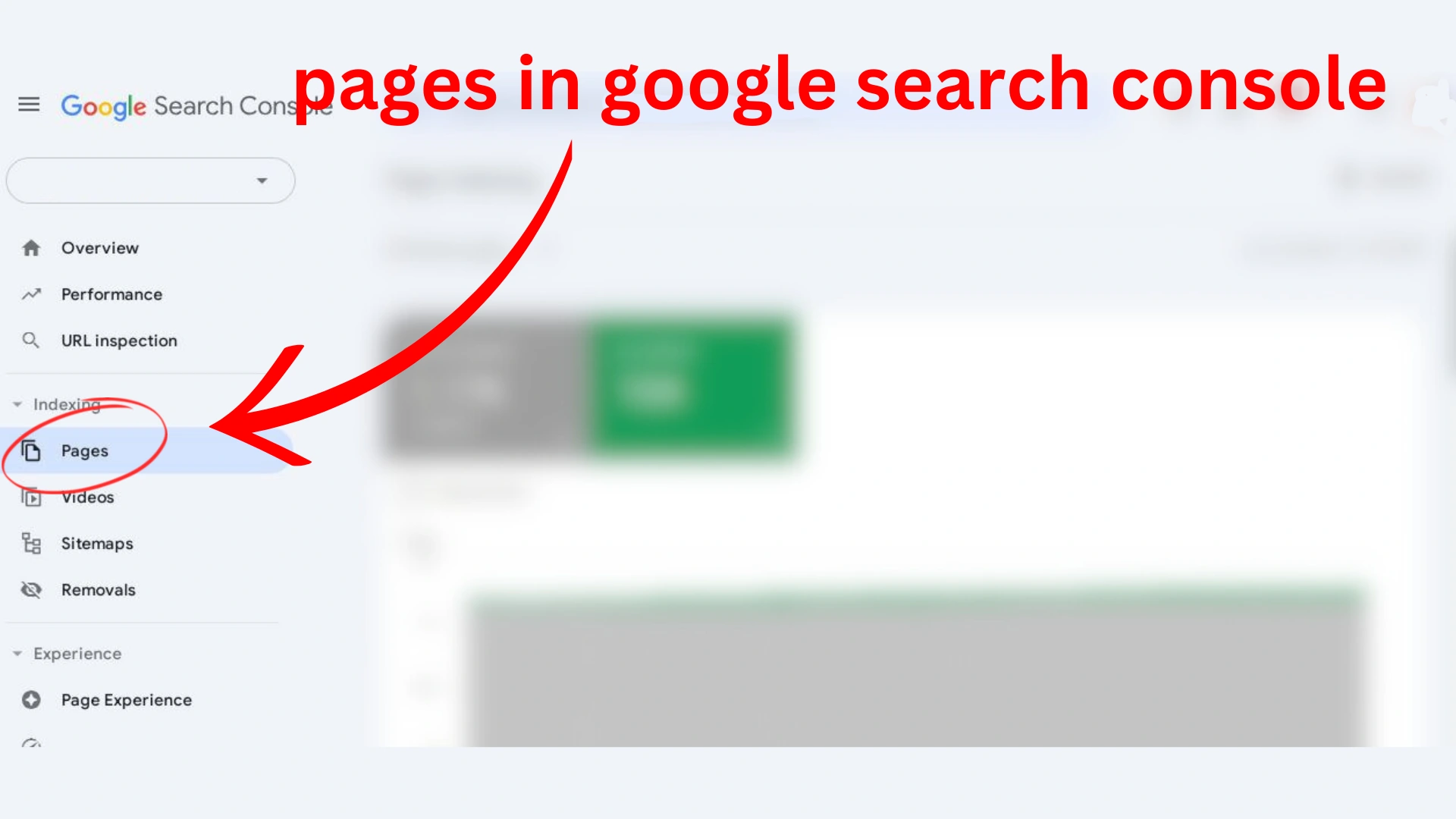

نکته مهمی که در این باره وجود دارد این است که بهراحتی میتوان خطای مورد نظر را یافت. تنها کافیست به سرچ کنسول گوگل سر بزنید و با سرچ خطا آن را در این بخش پیدا کنید.

وارد Google Search Console شوید.

به بخش Pages در تب Indexing بروید.

اگر صفحاتی “blocked by robots.txt” باشند، در این بخش نمایش داده میشوند.

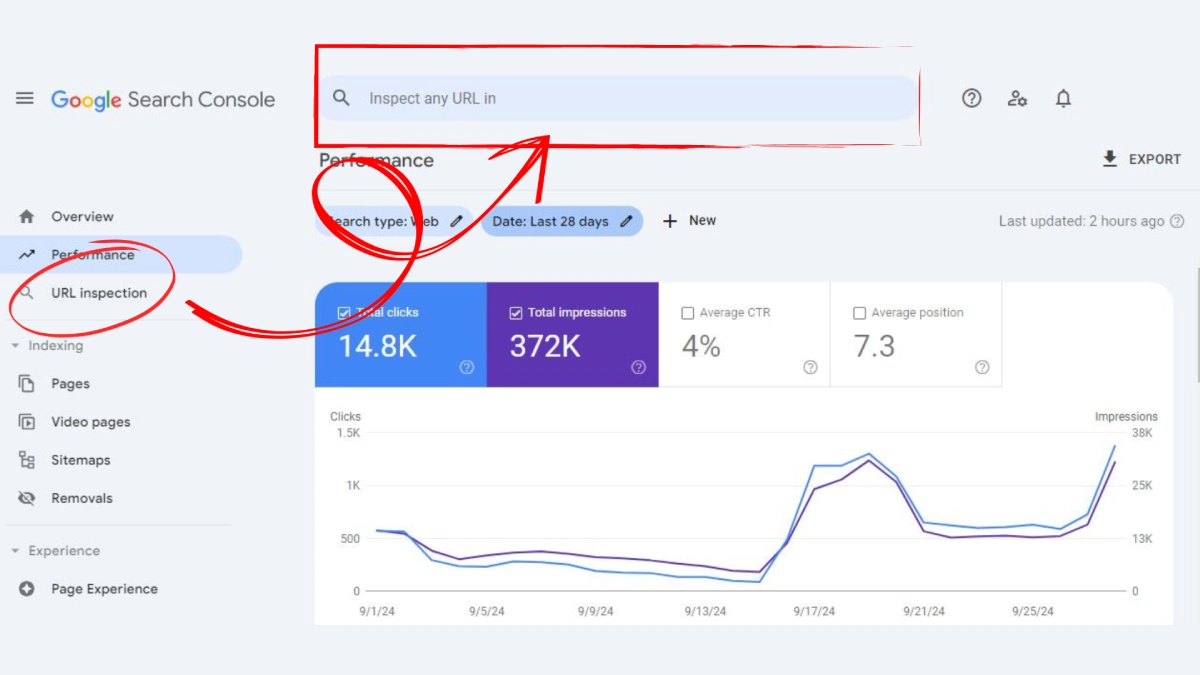

همچنین میتوانید از URL Inspection Tool برای بررسی یک آدرس خاص استفاده کنید.

اگر صفحه در دسترس نیست، پیامهایی مانند:

“Page is not indexed: Blocked by robots.txt”

یا

“URL is blocked by robots.txt”

نمایش داده میشود.

ایندکسکردن چه ربطی به بلاک صفحات دارد؟

درحالی که رابطه بین robots.txt و فرآیند نمایهسازی ممکن است گیجکننده باشد، درک مفاهیم عمیق به یادگیری آن کمک میکند. در اینجا به برخی از مهمترین این مفاهیم اشاره شده است:

کشف، خزیدن و نمایهسازی چطور کار میکند؟

قبل از اینکه یک صفحه ایندکس شود، خزندههای موتور جستجو باید سایت و صفحه را کشف و به خزش آن کمک کنند. در مرحله کشف خزنده متوجه میشود که یک URL مشخص وجود دارد و باید روی آن کار کند. در حین خزش بات گوگل از آن URL دیدن میکند و اطلاعات آن را بهدست میآورد. تنها کمی پس از آن URL به فهرست جستجو میرود و در میان سایر نتایج دیده میشود. البته این نکته را باید ذکر کرد که روند مذکور همیشه تا این حد کامل و بینقص نیست و با مشکلات متعددی مواجه میشود.

پارامتر txt.Robots چیست؟

پارامتر یا فایل Robots.txt فایلی است که جهت کنترل نحوه خزیدن ربات گوگل در وبسایت استفاده میشود. هر زمان که دستور Disallow را در آن قرار میدهید بات گوگل میداند از صفحات زیرمجموعه آن بازدید کند. شایان ذکر است که این فایل نمایهسازی را کنترل نمیکند و تاثیر چندانی روی این مورد ندارد.

دلیل ایندکسشدن صفحات بلاک شده در سرچ کنسول گوگل

گاهی گوگل تصمیم می گیرد که یک صفحه کشف شده را با وجود اینکه نمیتواند بخزد و محتوای آن را درک کند ایندکس کند. در این سناریو معمولا گوگل توسط پیوندهای زیادی که به صفحه مسدود شده مرتبط هستند تحریک میشود. این پیوندها به مرور به امتیازی برای رنکینگ پیج تبدیل میشوند. در این شرایط رباتهای گوگل آن را بررسی میکنند که مطمئن شوند یک صفحه مهم است یا اهمیتی ندارد. از طرفی با استفاده از الگوریتمهای رنکینگ پیج پیوندهای داخلی و خارجی را در نظر میگیرد. در این وضعیت ممکن است صفحهای را که خیلی مهم است در فهرست جستجو قرار دهد. پس ایندکسبودن یک فایل تاثیر قابل توجهی در جلوگیری از Blocked by robots خواهد داشت که نباید نادیده گرفته شود.

صفحات ایندکس شده با وجود خطای بلاک با ربات تاثیر منفی دارند

وضعیت یک صفحه ایندکس شده با وجود خطای blocked by robot یک مشکل جدی است که باید بررسی شود. شاید تصور کنید که موضوع پیچیده و عجیبی نیست، اما همین موضوع به ظاهر ساده سئوی سایت شما را تحت تاثیر قرار میدهد. در واقع چنین صفحاتی کیفیت کار و قدرت وبسایت شما را تحتالشعاع قرار میدهند و باید در اولین فرصت رفع شوند. ظاهر ضعیف اصلیترین دلیل عدم موفقیت چنین وبسایتی است. چنانچه یک صفحه را به اشتباه مسدود کرده باشید ولی ایندکس شود به معنی ضعف گوگل در تشخیص گوگل نیست. این صفحات به محض انتشار با ظاهری نامناسب نشان داده میشوند و این سندی بر ضعف کاری شما است.

در واقع چنین صفحاتی بههیچ عنوان جذاب نیستند و کسبوکار و برند مورد نظر را زیر سوال میبرند. گوگل قدرت نمایش برخی بخشها مانند برچسب عنوان، توضیحات متا و اطلاعات اضافی را ندارد. بدون این عناصر کاربران نمیدانند پس از ورود به صفحه چه چیزی در انتظارشان است و چه میبینند. حتی این احتمال وجود دارد که وبسایتهای رقیب را انتخاب کنند که در نتیجه CTR شما به شدت کاهش مییابد. درحالی که صفحات ایندکس شدهاند، اما بدون هیچگونه اطلاعات مهمی نمایش داده نمیشوند و این یک ضعف است. این بهدلیل عدم توانایی گوگل در خزش صفحات است و اطلاعات نادرست را نشان میدهد.

چگونه خطای Blocked by robots رفع میشود؟

پیش از هرگونه اقدام جهت رفع این مشکل از پیکربندی سایت مطمئن شوید و آن را بهدرستی بررسی کنید. میتوان با استفاده از ابزار تست این فایل را آزمایش و مورد ارزیابی قرار دهید و از دقیقبودن دستورالعملهای آن مطمئن شوید. چنانچه از وجود دستورالعملهایی در فایل robot.txt مطلع شدید که مانع دسترسی سایت به بات گوگل میشود آنها را حل کنید. حذف این دستورالعملها یا جایگزینکردن آن راهکاری عالی خواهد بود. برای حل این مشکل میتوان روشهای زیر را دنبال کرد:

1. فایل تست Robot.txt را باز کنید

فایل تستی که جهت ارزیابی این ربات دارید را باز و در میان وبسایتهای مختلف وبسایت خود را انتخاب کنید. با این کار دستور بارگذاری سایت خود را به گوگل دادهاید که خود در بررسی دقیق آن کمک میکند.

2. آدرس وبسایت را وارد کنید

در قسمت پایینی از فایل تست یک نوار سرچ وجود دارد که میتوان از این طریق URL سایت خود را وارد کرد. حتما نام سایت را با دقت کامل و با تمام جزئیات وارد کنید؛ چرا که احتمال وجود سایت مشابه است و باید بررسی شود.

3. گزینه User Agent را وارد کنید

در قسمت راست کادر این ابزار تست یک منوی کشویی وجود دارد که به آن User Agent میگویند. از این طریق میتوان گزینه مورد نظر خود یعنی Googlebot را انتخاب کرد.

4. اعتبارسنجی کنید

در مرحله آخر با کلیک روی دکمه Test میتوان فایل را ارزیابی و اعتبارسنجی کرد. چنانچه ربات خزنده فایل مورد نظر به آدرس سایت دسترسی داشته باشد اعتبارسنجی خیلی سریع اتفاق میافتد. بنابراین با کلیک روی دکمه Test مشخص میشود که سایت شما بلاک شده یا تاییدیه گرفته است.

5. ویرایش کنید

ممکن است در این مسیر ربات ارزیاب با مشکلاتی مواجه شود و کد یا بخشی را نادرست بزند. بهترین کار این است که دستور را داخل ویرایشگر کد ویرایش و بار دیگر مراحل را از اول اجرا کنید.

علاوهبر مواردی که ذکر شد گاهی علت ایجاد خطای مذکور واردکردن اشتباه دستورات یا کاربرد غلط آنها است. در این میان میتوان به مهمترین دستور یعنی Disallow اشاره کرد که به دو شکل بهکار میرود و موجب این خطا میشود:

6. استفاده اشتباه از دستور Disallow

در این شرایط اگر بهدنبال رفع خطا هستید باید دستور مذکور را حذف کنید؛ چرا که موجب مسدودشدن صفحه میشود. چنانچه تعداد زیادی URL دارید حتما آنها را در گوگل فیلتر کنید. با کلیک روی وضعیت و انتخاب نماد هرم معکوس آدرس مورد نظر را انتخاب کنید. میتوان تمام صفحاتی که دچار این خطا هستند را فیلتر کرد. بهتر است مسیر هر URL را در جای خود قرار دهید و از دستورالعملها پیروی کنید. در زمان تغییر ربات دستورالعملهای مورد نظر را با استفاده از ابزار تست ارزیابی کنید.

فراموش نکنید که ابزارهای تست فایل شما را به صورت اتوماتیک تغییر نمیدهند، پس باید دستورالعملها را بهصورت دستی وارد کنید. یک افزونه مهم به نام Robots Exclusion Checker وجود دارد که میتوان روی گوگل کروم نصب کرد. این افزونه به شما کمک میکند تا صفحات بلاک شده را برای هر دامنهای که مد نظر دارید مشاهده کنید. با این کار میتوان حتی URL های بلاک شده خود را یافت و آنها را تنظیم کرد.

7. استفاده عمدی از دستور Disallow

میتوان با نادیدهگرفتن وضعیت Blocked by robots.txt در سرچ کنسول گوگل وضعیت فوق را ادامه دهید. فراموش نکنید که مسدودکردن ربات به دلیل محتوای کم یا غیراستاندارد کاملا طبیعی و عادی است. این عامل موجب عدم خزش توسط رباتها خواهد شد، پس باید فکری به حال این وضعیت کرد. برای این کار پیشنهاد میشود که برای وبسایت خود یک استراتژی خزیدن درست انتخاب کنید. این کار کمک میکند تا بودجه خزش خود را بهینه کنید و حتی آن را بهبود دهید.

چگونه مانع تکرار خطا شویم؟

همانطور که تا اینجا خواندید مشاهده چنین اخطاری موجب کلافگی و دردسر شما خواهد شد؛ بنابراین از تکرار آن جلوگیری کنید. برای این کار بهتر است به صورت مداوم robot.txt وب سایت خود را مرور و بهروز کنید. با این کار مطمئن خواهید شد که تمام اطلاعات و نکات مربوط به سایت شما آپدیت میشوند. با کمک ابزارهای تست روزانه یا دورهای میتوان این کار را انجام داد. بهطور کلی جهت پرداختن به این مشکل باید دو رویکرد را بررسی کرد:

- درصورتی که بهدنبال ایندکس صفحه هستید.

- درصورتی که قصد ایندکس صفحه را ندارید.

رفع خطای Blocked by robots بهکمک راهکارهای طلایی کافه سئو

طبق نکاتی که در مقاله حاضر به آنها اشاره شد یکی از خطاهای رایج و تاثیرگذار در وبسایت خطای Blocked by robots است. این خطا در بسیاری از موارد موجب تنزل جایگاه وبسایت شما خواهد شد و آن را به رتبههای پایین میکشاند. نکته جالب اینجاست که بسیاری از سایتهایی که با این خطا مواجه هستند ایندکس شدهاند. در واقع خطای مذکور کمی بیشتر از حد انتظارات ما قدرتمند است و باید از پا در آید. نیازی به نگرانی نیست، با کمک کارشناسان خبره ما در کافه سئو میتوانید این مشکل را در کوتاهترین زمان حل کنید. شایان ذکر است که پیش از هر کاری بهتر است از فردی متخصص کمک بگیرید و خود اقدامی انجام ندهید.